ollama

摘要

- 简介:用于下载,并部署大模型。下载完成后,可以通过命令行的模式运行大模型,如果要UI界面,需要MaxKB、CherryStudio等界面。

- 官网:https://ollama.com/

- 前置要求:WSL

- 配置要求:You should have at least 8 GB of RAM available to run the 7B models, 16 GB to run the 13B models, and 32 GB to run the 33B models.

-

安装:有两个选择,一个是直接官网下载,安装在;一个是用Docker安装在容器中

-

方案一:通过官网直接下载安装(安装在宿主机)

-

方案二:Docker安装

-

# 创建网络是为了让后续的知识库等容器更容易访问到ollama容器(官方推荐做法) docker network create my-network # -v是指定ollama下载模型的存储位置 docker run -d --name ollama --network my-network -p 11434:11434 -v [ollama数据存储位置]:/root/.ollama ollama/ollama -

通过Docker装完ollama,为啥0.0.0.0:11434可以访问ollama,host.docker.internal:11434无法访问(显示502)1

- 因为此时,在宿主机上,应该用

localhost:11434来访问容器,host.docker.internal:11434是用于从容器访问宿主。 - 比如,ollama直接官网下载,运行exe安装到windows本机;知识库是通过Docker安装在容器里,那知识库设置里需要填写的ollama地址就是

host.docker.internal:11434。

- 因为此时,在宿主机上,应该用

-

当我用Docker安装了另一个知识库程序,需要在知识库的设置里填写ollama的访问URL,我应该填哪一个?2

-

分为4种情况

- ollama(容器),知识库(宿主):http://localhost:11434

- ollama(宿主),知识库(容器):http://host.docker.internal:11434

-

ollama(容器),知识库(容器)

-

方案一:

- 获取ollama的Docker容器地址:

docker inspect -f '' ollama - 假设得到的IP是172.17.0.2,那么在知识库程序中应配置:http://172.17.0.2:11434

- 缺点:容器重启后IP可能变化,不推荐。

- 获取ollama的Docker容器地址:

-

方案二:

- 如果已经跑起来了ollama和知识库,需要先

docker stop和docker rm - 创建自定义网络(如果还没创建):

docker network create my-network - 启动Ollama容器时加入该网络:

docker run -d --name ollama --network my-network -p 11434:11434 ollama/ollama - 启动知识库容器时也加入同一网络:

docker run -d --name knowledge-base --network my-network -p 3000:3000 your-knowledge-base-image - 在知识库程序的设置中,Ollama的URL配置为:

http://ollama:11434 注意:这里使用容器名称(ollama)作为主机名,因为Docker的自定义网络内置了DNS解析,可以通过容器名称解析。

- 如果已经跑起来了ollama和知识库,需要先

-

-

-

-

-

目前知识库使用模型:bge-m3

-

基本命令:参考链接

-

# 检查ollama版本 ollama --version # 安装bge-m3模型 ollama run bge-m3:latest # 检查ollama已安装的大模型 ollama list #检查ollama正在运行的大模型 ollama ps

-

-

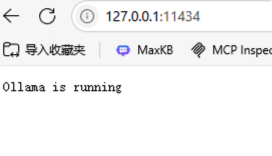

本机访问

127.0.0.1:11434orhttp://host.docker.internal:11434/,确保ollama在运行,供后续MaxKB、Dify等使用

-

详细记录

当我用Docker安装了另一个知识库程序,需要在知识库的设置里填写ollama的访问URL,我应该填哪一个?2

分为4种情况

- ollama(容器),知识库(宿主):http://localhost:11434

- ollama(宿主),知识库(容器):http://host.docker.internal:11434

ollama(容器),知识库(容器)

方案一:

- 获取ollama的Docker容器地址:

docker inspect -f '' ollama- 假设得到的IP是172.17.0.2,那么在知识库程序中应配置:http://172.17.0.2:11434

- 缺点:容器重启后IP可能变化,不推荐。

方案二:

- 如果已经跑起来了ollama和知识库,需要先

docker stop和docker rm- 创建自定义网络(如果还没创建):

docker network create my-network- 启动Ollama容器时加入该网络:

docker run -d --name ollama --network my-network -p 11434:11434 ollama/ollama- 启动知识库容器时也加入同一网络:

docker run -d --name knowledge-base --network my-network -p 3000:3000 your-knowledge-base-image- 在知识库程序的设置中,Ollama的URL配置为:

http://ollama:11434 注意:这里使用容器名称(ollama)作为主机名,因为Docker的自定义网络内置了DNS解析,可以通过容器名称解析。

通过Docker装完ollama,为啥0.0.0.0:11434可以访问ollama,host.docker.internal:11434无法访问(显示502)1

- 因为此时,在宿主机上,应该用

localhost:11434来访问容器,host.docker.internal:11434是用于从容器访问宿主。- 比如,ollama直接官网下载,运行exe安装到windows本机;知识库是通过Docker安装在容器里,那知识库设置里需要填写的ollama地址就是

host.docker.internal:11434。

-

# 通过Docker装完ollama,为啥0.0.0.0:11434可以访问ollama,host.docker.internal:11434无法访问(显示502)

摘要

- 因为此时,在宿主机上,应该用

localhost:11434来访问容器,host.docker.internal:11434是用于从容器访问宿主。 - 比如,ollama直接官网下载,运行exe安装到windows本机;知识库是通过Docker安装在容器里,那知识库设置里需要填写的ollama地址就是

host.docker.internal:11434。

详细记录

我们首先要理解Docker中网络的基本知识:

- 当容器内服务监听0.0.0.0时,表示监听所有网络接口(包括容器内部的回环和外部映射的网络接口)。

- 在Docker容器内部,

host.docker.internal是一个特殊的主机名,用于从容器内部解析到宿主机的网络地址。这个名称在Windows和Mac的Docker Desktop中可用,目的是让容器能够访问宿主机上运行的服务。

问题描述:

- 在容器内部,通过0.0.0.0:11434可以访问(比如在容器内部执行curl 0.0.0.0:11434 可以通),但通过host.docker.internal:11434却返回502(Bad Gateway)。

原因分析:

-

端口映射问题:使用

host.docker.internal是从容器内部访问宿主机的服务,而不是访问容器本身。这里存在两种不同的方向:- 访问容器自身:在容器内部,直接访问0.0.0.0:11434,这是访问容器自己监听的端口,当然可以通。

- 访问宿主机:当从容器内部使用

host.docker.internal时,意思是访问宿主机的网络。如果宿主机上没有运行一个监听11434端口的服务,那么就会连接失败(比如连接被拒绝或超时)。而502错误通常表示作为网关或代理的服务器,从上游服务器接收到无效的响应。在这个场景下,502可能是因为我们实际上在容器内部,然后试图通过host.docker.internal:11434去访问宿主机,但是宿主机上并没有服务监听这个端口。

- 反向代理配置错误(常见于Web应用) :如果ollama在容器内运行,并且配置了某种反向代理(比如Nginx),那么当使用

host.docker.internal时,请求被发送到了宿主机,然后宿主机上的反向代理可能被配置为将请求转发到容器,但配置错误导致502。 - 端口未暴露给宿主机:在运行容器时,如果没有使用

-p参数将容器的端口映射到宿主机端口,那么宿主机上的11434端口并没有被占用,也没有服务监听。此时,在容器内部访问host.docker.internal:11434试图访问宿主机的11434端口,由于没有服务,所以会失败(但502错误通常不是这种情况,因为连接不到服务通常会是连接拒绝或超时)。 - Docker Compose 或 自定义网络中的问题:如果在同一个Docker网络中,有其他容器(比如一个反向代理容器)在监听11434端口,并且它试图将请求代理到

ollama服务,但ollama服务没有正常运行,或者代理配置的地址不正确,那么访问这个反向代理容器时就会返回502。

但是,这里要注意:题目中提到的是直接访问

host.docker.internal:11434,所以我们需要明确:这个访问是发生在哪里?- 如果访问发生在容器内部(比如在容器内部使用curl访问host.docker.internal:11434),那么我们要看宿主机上是否有服务监听11434。

- 如果访问发生在宿主机上(比如在宿主机的浏览器访问host.docker.internal:11434),那么请注意,

host.docker.internal在宿主机上解析为什么?实际上,在Windows/Mac的Docker Desktop环境中,宿主机上的host.docker.internal会被解析为宿主机的回环地址(127.0.0.1)或者一个特定的网关地址(在Windows中,可能是10.0.75.1)。这时,如果宿主机上没有服务监听11434端口,那么也会失败。

然而,502错误通常出现在反向代理场景。因此,我们假设这里有一个反向代理设置。

常见情况还原:

假设你运行了一个反向代理(比如Nginx)在另一个容器中,或者直接在宿主机上运行了一个反向代理,它监听宿主机的11434端口,并将请求转发到容器。那么,如果转发配置有问题(比如容器内的ollama没有正常运行,或者反向代理配置的上游地址错误),就可能返回502。

解决方案:

-

检查端口映射:

确保运行ollama容器时,使用了端口映射,比如:docker run -d -p 11434:11434 --name ollama ollama/ollama这样,宿主机上的11434端口就会被映射到容器内的11434端口。

- 在宿主机上访问:

在宿主机上,你应该使用localhost:11434或者127.0.0.1:11434来访问ollama服务。在宿主机上,host.docker.internal并不是用来访问容器的,而是用于容器内访问宿主机。所以,在宿主机上直接访问容器映射出来的端口用localhost即可。 - 在容器内部访问宿主机上的服务:

如果你想在容器内部访问运行于宿主机上的服务(比如宿主机上运行了一个数据库,监听3306端口),那么你在容器内部应该使用host.docker.internal:3306来访问宿主机的3306端口。但这与ollama服务无关。 -

检查ollama是否正常运行:

进入容器内部,检查ollama服务是否正常:docker exec -it ollama curl 0.0.0.0:11434如果返回正常,则说明容器内服务正常。

-

在宿主机上验证端口:

在宿主机上运行:curl localhost:11434如果返回正常,则说明端口映射成功。

- 避免使用host.docker.internal访问容器自身:

在容器内部,如果需要访问自己容器内运行的服务,请使用容器IP(可以通过hostname -i命令查看,通常是172.17.0.x),或者直接使用0.0.0.0或127.0.0.1(如果服务监听0.0.0.0则可以用127.0.0.1)。不需要使用host.docker.internal。 - 如果是反向代理导致的502:

检查反向代理配置是否正确。例如,在Nginx配置中,确保代理的上游地址是容器的名称(在Docker网络中)或者容器的IP(通常不推荐,因为IP会变)和正确的端口。

总结:

- 直接访问

0.0.0.0:11434在容器内部成功,是因为访问的是容器自身的服务。 - 使用

host.docker.internal:11434在容器内部访问失败(502),可能是因为你试图访问宿主机上的11434端口,而宿主机上并没有服务监听这个端口(除非你映射了并且ollama在宿主机上监听,但ollama是在容器内运行),或者宿主机上的反向代理配置错误。

所以,正确的做法应该是:

- 在宿主机上访问容器映射的端口:

localhost:11434 - 在容器内部访问容器自身的服务:

127.0.0.1:11434 或0.0.0.0:11434 - 避免在容器内部使用

host.docker.internal来访问容器自身的服务。

如果问题是在宿主机上访问

host.docker.internal:11434返回502,那么请检查宿主机上是否有其他服务(如反向代理)占用了11434端口,并检查它的配置。在宿主机上,访问容器映射的端口应该使用localhost:11434,而不是host.docker.internal:11434,因为host.docker.internal在宿主机上解析为宿主机自己的一个地址,这个地址并不是容器映射的端口的目标地址。您遇到的问题源于对 Docker 网络模型的理解偏差。当您通过

0.0.0.0:11434 可以访问 Ollama 但host.docker.internal:11434 返回 502 错误时,根本原因是 访问目标和网络路径不同,以下是详细分析:

🧩 问题核心:网络访问路径差异

访问方式 目标对象 网络路径 适用场景 0.0.0.0:11434容器自身服务 容器内部回环地址 在容器内部测试自身服务 host.docker.internal:11434宿主机服务 容器 → Docker网关 → 宿主机 容器内访问宿主机运行的服务 您实际需要访问的是 容器内的 Ollama 服务,但错误地尝试从容器内去访问宿主机的服务端口,而 Ollama 并不在宿主机运行。

🔍 502 错误产生的具体原因(逐步分析)

1. 网络拓扑关系

+-------------------------------------+ | 宿主机 (Windows) | | | | +-----------------------------+ | | | Docker 容器 | | | | +---------------------+ | | | | | Ollama 服务 | | | | | | 监听: 0.0.0.0:11434 | | | | | +--------↑------------+ | | | | | | | | | 容器内部访问 | | | +----------|------------------+ | | ↓ | | 宿主端口映射: -p 11434:11434 | | | +-------------------------------------+2. 错误访问路径解析

当您在 容器内部 执行:

curl http://host.docker.internal:11434实际发生了:

- 请求指向宿主机 (

host.docker.internal ≈ 宿主IP) - 宿主机11434端口由Docker映射到容器

- 但请求又返回到容器自身,形成环回

- Ollama 服务收到无效请求 → 返回 502 Bad Gateway

3. 502 响应的本质

Ollama 作为服务端,收到了一个指向自身的网关请求(类似反向代理配置错误),无法正确处理,因此返回:

HTTP/1.1 502 Bad Gateway

✅ 正确访问方式(根据场景选择)

场景1:在容器内部访问 Ollama

# 在容器内部使用 curl http://localhost:11434 # 首选 curl http://127.0.0.1:11434 # 明确回环地址 curl http://0.0.0.0:11434 # 监听所有接口场景2:在宿主机访问容器内的 Ollama

# 在 Windows CMD/PowerShell 中 curl http://localhost:11434场景3:其他容器访问 Ollama 容器

# 创建共享网络 docker network create ollama-net # 启动Ollama容器(加入网络) docker run -d --network ollama-net --name ollama -p 11434:11434 ollama/ollama # 启动另一个容器访问Ollama docker run --rm --network ollama-net curlimages/curl \ curl http://ollama:11434

⚠️ 特别注意事项:Windows 下的网络配置

1. 端口冲突检测

检查宿主端口占用:

# PowerShell Get-Process -Id (Get-NetTCPConnection -LocalPort 11434).OwningProcess2. WSL 2 后端限制

在 Docker Desktop 设置中:

- 进入 Settings → Resources → WSL Integration

- 确保勾选 “Enable integration with my default WSL distro”

- 重启 Docker

3. 防火墙规则

允许 Docker 穿透防火墙:

New-NetFirewallRule -DisplayName "Allow Docker Port 11434" ` -Direction Inbound -LocalPort 11434 -Protocol TCP -Action Allow

🔄 验证步骤(快速排错)

-

宿主机直接访问测试

# Windows 终端 curl.exe http://localhost:11434应返回 Ollama 的 API 信息

-

容器内部自检

docker exec ollama curl -s http://localhost:11434 -

网络拓扑检查

# 查看容器IP docker inspect ollama -f "" # 在容器内测试宿主可达性 docker exec ollama ping host.docker.internal

📝 典型修复方案(命令示例)

案例:容器内服务自检通过,但宿主访问失败

# 1. 移除旧容器 docker stop ollama docker rm ollama # 2. 创建持久化存储 mkdir C:\ollama_data # 3. 重新运行并正确映射端口 docker run -d \ --name ollama \ -p 11434:11434 \ -v C:\ollama_data:/root/.ollama \ ollama/ollama # 4. 测试 curl http://localhost:11434/api/tags📊 访问矩阵总结

发起位置 目标 正确地址 错误地址(导致502) 容器内部 Ollama 服务 localhost:11434 host.docker.internal:11434Windows 主机 Ollama 服务 localhost:11434 host.docker.internal:11434其他容器 Ollama 服务 ollama:11434(容器名)宿主IP:11434 关键结论:

host.docker.internal 是专门用于 容器内访问宿主机服务 的特殊域名,而非用于访问容器自身服务。正确使用本地回环地址(localhost/127.0.0.1)即可解决502问题。 ↩ ↩2 - 因为此时,在宿主机上,应该用

-

# 当我用Docker安装了另一个知识库程序,需要在知识库的设置里填写ollama的访问URL,我应该填哪一个?

摘要

-

分为4种情况

- ollama(容器),知识库(宿主):http://localhost:11434

- ollama(宿主),知识库(容器):http://host.docker.internal:11434

-

ollama(容器),知识库(容器)

-

方案一:

- 获取ollama的Docker容器地址:

docker inspect -f '' ollama - 假设得到的IP是172.17.0.2,那么在知识库程序中应配置:http://172.17.0.2:11434

- 缺点:容器重启后IP可能变化,不推荐。

- 获取ollama的Docker容器地址:

-

方案二:

- 如果已经跑起来了ollama和知识库,需要先

docker stop和docker rm - 创建自定义网络(如果还没创建):

docker network create my-network - 启动Ollama容器时加入该网络:

docker run -d --name ollama --network my-network -p 11434:11434 ollama/ollama - 启动知识库容器时也加入同一网络:

docker run -d --name knowledge-base --network my-network -p 3000:3000 your-knowledge-base-image - 在知识库程序的设置中,Ollama的URL配置为:

http://ollama:11434

注意:这里使用容器名称(ollama)作为主机名,因为Docker的自定义网络内置了DNS解析,可以通过容器名称解析。

- 如果已经跑起来了ollama和知识库,需要先

-

详细记录

我们正在解决的是:在一个Docker化的知识库程序中配置Ollama服务的访问地址。

背景:

- Ollama服务运行在一个Docker容器中(假设容器名为ollama),暴露端口11434给宿主机和其他容器。

- 知识库程序也运行在Docker容器中(假设容器名为knowledge-base),需要配置Ollama的URL。

关键点:两个容器在Docker网络中的相互访问方式。

根据两个容器是否在同一个Docker网络中,配置方式不同:

情况一:两个容器使用默认网络(即没有创建自定义网络,都在默认的bridge网络)

- 默认情况下,容器之间通过IP地址访问。

- 先获取Ollama容器的IP地址:

docker inspect -f '' ollama - 假设得到的IP是172.17.0.2,那么在知识库程序中应配置:http://172.17.0.2:11434

- 缺点:容器重启后IP可能变化,不推荐。

情况二:将两个容器连接到同一个自定义网络(推荐)

步骤:

- 创建自定义网络(如果还没创建):

docker network create my-network - 启动Ollama容器时加入该网络:

docker run -d –name ollama –network my-network -p 11434:11434 ollama/ollama - 启动知识库容器时也加入同一网络:

docker run -d –name knowledge-base –network my-network -p 3000:3000 your-knowledge-base-image - 在知识库程序的设置中,Ollama的URL配置为:http://ollama:11434

注意:这里使用容器名称(ollama)作为主机名,因为Docker的自定义网络内置了DNS解析,可以通过容器名称解析。

情况三:知识库程序在宿主机运行(非Docker),而Ollama在Docker容器中

- 配置:http://localhost:11434

因为Ollama容器将端口映射到了宿主机的11434端口。

情况四:知识库程序在Docker容器中,但Ollama在宿主机上运行(而不是容器内)

- 这种情况较少见(因为Ollama也是Docker安装的),但假设有:在宿主机运行了Ollama(比如直接安装的Ollama,监听11434)。

- 那么,在知识库容器中配置时,使用Docker提供的特殊DNS名称:host.docker.internal

配置:http://host.docker.internal:11434

注意:host.docker.internal 是Docker为容器提供的一个指向宿主机(在Windows/macOS上有效,Linux需要特殊处理)的特殊域名。

我们的场景:

- 根据之前对话,Ollama是通过Docker安装并运行在容器中的。

- 知识库程序也是Docker容器。

因此,最推荐的是情况二:使用自定义网络,通过容器名称访问。

操作步骤:

-

停止并删除现有容器(如果有):

docker stop ollama

docker rm ollama### 同样处理知识库容器(如果已经创建)

- 创建自定义网络(如果尚未创建):

docker network create my-net - 启动Ollama容器并加入自定义网络:

docker run -d –name ollama –network my-net -p 11434:11434 ollama/ollama - 启动知识库容器并加入同一网络:

docker run -d –name knowledge-base –network my-net -p 3000:3000 knowledge-base-image - 在知识库程序的配置界面中,设置Ollama的URL为:http://ollama:11434

验证:

- 进入知识库容器的shell:

docker exec -it knowledge-base /bin/sh - 在容器内部尝试访问Ollama:

curl http://ollama:11434

应该能返回Ollama的响应。

注意:如果知识库程序运行在非容器环境(如直接运行在Windows宿主机上),那么它应该通过localhost:11434访问Ollama。

总结:

- 如果知识库程序是Docker容器,且和Ollama在同一个自定义网络中:http://ollama:11434

- 如果知识库程序运行在宿主机上:http://localhost:11434

请根据实际情况选择配置。

要正确配置知识库程序访问 Ollama 服务,访问地址的选择取决于您的容器部署方式和网络架构。以下是详细指南:

⚙️ 根据部署场景选择正确的访问 URL

部署场景 推荐访问 URL 说明 Ollama 和知识库在同一主机,且知识库是 Docker 容器 http://ollama:11434最佳实践,使用容器名访问(需要自定义网络) Ollama 和知识库在同一主机,知识库运行在宿主机(非容器) http://localhost:11434标准主机访问方式 Ollama 单独容器,知识库运行在宿主机 http://localhost:11434宿主机通过端口映射访问 知识库容器使用默认网桥网络 http://<ollama容器IP>:11434临时方案(需获取容器动态IP) 跨主机访问 http://<主机公网IP或域名>:11434生产环境需安全配置(防火墙、HTTPS等)

🧩 最推荐方案:使用自定义 Docker 网络(容器间直接通信)

步骤 1:创建专用网络

docker network create knowledge-net步骤 2:启动 Ollama 容器(加入网络)

docker run -d \ --name ollama \ --network knowledge-net \ -v ollama_data:/root/.ollama \ ollama/ollama步骤 3:启动知识库容器(加入同一网络)

docker run -d \ --name knowledge-base \ --network knowledge-net \ -p 8080:8080 \ your-knowledge-image步骤 4:在知识库程序中配置 Ollama URL

http://ollama:11434✅ 优势:

- 使用容器名(

ollama)替代 IP,自动 DNS 解析 - 网络隔离更安全

- 容器重启后地址不变

- 无需暴露端口到宿主机(除非需要外部访问)

🔍 验证连接(容器内测试)

# 进入知识库容器 docker exec -it knowledge-base sh # 测试 Ollama 连接 curl http://ollama:11434预期返回:

{"status":"Ollama is running"}

⚠️ 常见问题排查

-

连接拒绝/超时

- 确认 Ollama 正常运行:

docker logs ollama -

检查网络连通性(在知识库容器执行):

ping ollama nslookup ollama

- 确认 Ollama 正常运行:

-

容器无法解析名称

确保使用自定义网络(非默认网桥):docker inspect knowledge-base -f '' -

防火墙限制(跨主机时)

在主机的防火墙打开 11434 端口

📝 配置示例(不同知识库系统)

- LangChain/LLMStack 类系统

API Endpoint:http://ollama:11434/api/generate

Chat Endpoint:http://ollama:11434/api/chat -

本地知识库(如 LocalGPT)

# config.yml llm: api_url: "http://ollama:11434/v1" model: "llama3" -

Web UI 系统(如 Open WebUI)

# .env 配置文件 OLLAMA_API_BASE_URL=http://ollama:11434

💡 专业建议:在任何 Docker 部署中,优先使用自定义网络+容器名称的访问方式,这符合 Docker 的最佳实践,能避免 90% 以上的连接问题。只有在需要从外部主机访问时才考虑公网 IP 或端口转发。

-